深入AI测试领域,掌握核心技能与学习路线

在AI技术日益普及的今天,AI产品的质量保障成为关键环节。如何系统学习AI测试并掌握其核心技能?本文基于一线专家的实战经验,为你梳理出一条清晰的学习路径,涵盖业务理解、指标计算与性能测试三大阶段。

一、先理解业务场景,再制定测试策略

AI测试与传统软件测试最大的不同在于:业务场景直接决定测试策略。不同AI应用场景的测试方法差异巨大。

典型案例:推荐系统 vs 信用卡反欺诈

推荐系统(如抖音、起点小说等)的特点是高频自学习:模型可能按小时甚至分钟更新,特征随时间变化极快。测试策略必须以线上灰度发布和监控为主,传统线下测试完全跟不上节奏。

反欺诈模型则可能按月更新,有充足时间进行线下测试。如果照搬反欺诈的测试方法到推荐系统,等测试完成“黄花菜都凉了”。

学习建议:首先了解你所在领域的业务形态、盈利模式和运作方法,才能确定正确的测试策略。常见AI场景包括:

分类场景(如信用卡反欺诈)

推荐系统(内容推荐、广告推荐)

计算机视觉(目标检测、人脸识别、图像分割、OCR)

自然语言处理(机器翻译、情感分析)

文档解析(版面识别、元素提取)

智能体(RAG流程、多Agent协作)

二、模型指标学习:理论与实践结合

当你理解了业务场景后,就需要学习如何量化评估模型效果。不同场景需要关注不同的评估指标。

- 分类场景核心指标

分类模型最常用的指标包括:

准确率(Accuracy)

召回率(Recall)/命中率

精准率(Precision)/误报率

F1分数(F1-Score)

AUC(Area Under Curve)

这些指标都基于混淆矩阵(Confusion Matrix)计算,包括TP、TN、FP、FN四个维度。

- 代码实践:统计分类指标

import numpy as np

from sklearn.metrics import confusion_matrix, precision_score, recall_score, f1_score

假设我们有以下真实标签和预测结果

y_true = [1, 0, 1, 1, 0, 1, 0, 0]

y_pred = [1, 0, 1, 0, 0, 1, 1, 0]

计算混淆矩阵

tn, fp, fn, tp = confusion_matrix(y_true, y_pred).ravel()

print(f"TN: {tn}, FP: {fp}, FN: {fn}, TP: {tp}")

计算各项指标

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

print(f"精准率: {precision:.2f}")

print(f"召回率: {recall:.2f}")

print(f"F1分数: {f1:.2f}")

3. 计算机视觉目标检测指标

对于目标检测任务,除了上述指标外,还需要考虑IOU(Intersection over Union)指标,评估预测框与真实框的重合程度。

import cv2

import numpy as np

def calculate_iou(boxA, boxB):

# 计算两个框的交并比

xA = max(boxA[0], boxB[0])

yA = max(boxA[1], boxB[1])

xB = min(boxA[2], boxB[2])

yB = min(boxA[3], boxB[3])

# 计算交集区域

interArea = max(0, xB - xA + 1) * max(0, yB - yA + 1)# 计算两个框的各自面积

boxAArea = (boxA[2] - boxA[0] + 1) * (boxA[3] - boxA[1] + 1)

boxBArea = (boxB[2] - boxB[0] + 1) * (boxB[3] - boxB[1] + 1)# 计算交并比

iou = interArea / float(boxAArea + boxBArea - interArea)

return iou

示例:计算两个框的IOU

boxA = [10, 10, 50, 50] # [x1, y1, x2, y2]

boxB = [20, 20, 60, 60]

iou = calculate_iou(boxA, boxB)

print(f"IOU: {iou:.2f}")

4. 文档检索场景指标

对于文档检索、推荐系统等需要排序的场景,还需要关注:

Top-N召回率

MAP(Mean Average Precision)

余弦相似度计算

import numpy as np

from sklearn.metrics.pairwise import cosine_similarity

文档语义检索示例

def semantic_search(query_vector, doc_vectors, top_n=5):

"""

语义检索:计算查询与文档的余弦相似度并返回Top-N结果

"""

# 计算余弦相似度

similarities = cosine_similarity([query_vector], doc_vectors)[0]

# 获取相似度最高的前N个文档

top_indices = np.argsort(similarities)[::-1][:top_n]

top_similarities = similarities[top_indices]return top_indices, top_similarities

示例用法

query_vec = np.random.rand(300) # 300维查询向量

doc_vectors = np.random.rand(1000, 300) # 1000个文档,每个300维向量

top_docs, top_scores = semantic_search(query_vec, doc_vectors)

print(f"最相关的前5个文档: {top_docs}")

print(f"相似度分数: {top_scores}")

三、性能测试:深入系统架构

AI产品的性能测试需要深入理解系统架构和技术栈。

- 计算机视觉性能测试

对于视频流处理系统,需要关注:

每秒处理帧数(FPS)

端到端延迟

单GPU支持的路数(摄像头数量)

解码、预处理、推理、后处理的性能

- 智能体性能测试

对于智能体系统,需要关注:

响应时间(端到端耗时)

知识库检索性能(特别是百万/千万向量级别的检索)

并发处理能力

资源利用率

- 边缘计算场景

在边缘计算场景中,还需要测试:

模型下发性能

边缘节点管理能力

网络带宽占用

分布式协同效率

四、学习路径建议

阶段一:业务场景学习

先学习自己工作相关的场景

没有明确方向的从分类场景开始

逐步过渡到更复杂的推荐系统、计算机视觉等领域

目标:理解业务形态和测试策略制定原则

阶段二:模型指标学习

搭建实验环境(建议使用公有云服务,成本低且便捷)

学习不同场景的评估指标和计算方法

动手编写指标统计代码

目标:掌握核心指标的理论和实践

阶段三:性能测试深入学习

深入研究系统架构和技术栈

学习相关工具(OpenCV、FFmpeg等)

理解全链路性能瓶颈

目标:具备端到端性能测试能力

五、实践建议

利用公有云服务:各大云平台都提供AI模型服务,只需少量投入即可进行实践学习。

结合开源项目:下载开源模型进行实验,如YOLO用于目标检测,BERT用于文本处理等。

重视业务理解:AI测试不只是技术活,更需要深入理解业务场景和产品目标。

循序渐进:从简单场景开始,逐步过渡到复杂场景,避免一开始就陷入技术细节。

AI测试是一个充满挑战的领域,需要不断学习和技术更新。希望本文提供的学习路径和实践建议能帮助你在AI测试领域快速成长!

进一步学习资源:可以关注技术社区、开源项目以及各大云平台的AI服务文档,持续跟进最新的技术发展和最佳实践。

无论是刚入门的新手还是有一定经验的工程师,系统性地掌握AI测试技能都将为你的职业发展打开新的空间。

人工智能技术学习交流群

推荐学习

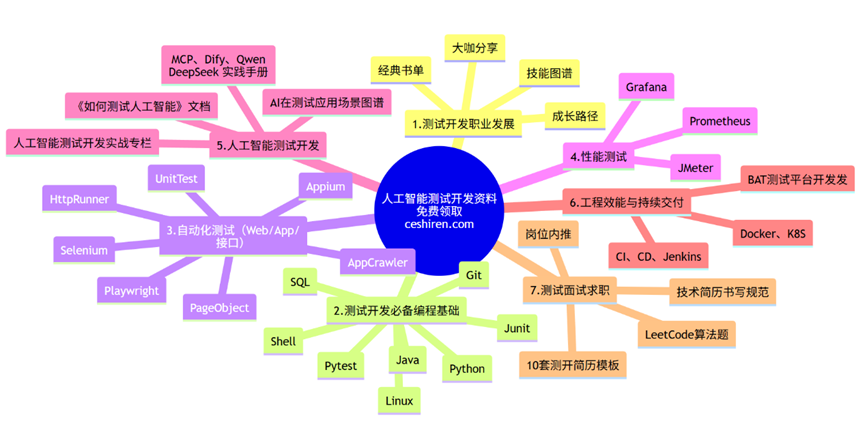

行业首个「知识图谱+测试开发」深度整合课程【人工智能测试开发训练营】,赠送智能体工具。提供企业级解决方案,人工智能的管理平台部署,实现智能化测试,落地大模型,实现从传统手工转向用AI和自动化来实现测试,提升效率和质量。