场景简介在本实验场景中,将使用Alibaba Cloud AI Containers(AC2)容器镜像服务,通过Docker容器镜像部署Qwen系列大语言模型。本实验场景基于第八代Intel实例,使用Alibaba Cloud Linux 3作为实验系统,使能Intel最新的 AI 加速指令集,提供完整的容器生态支持。 本实验场景无需深奥的AI背景知识,只要了解基本的Linux基础知识,能够使用命令行,就可以轻松完成本实验,体验大语言模型的对话能力,感受AIGC的魅力。 使用AI容器镜像的过程中,有任何疑问和建议,您可以加入钉钉群(群号33605007047)反馈,并获取技术支持。 背景知识本场景主要涉及以下云产品和服务:

|

|

|

|

|

|

云起实验室将在您的账号下开通本次实操资源,资源按量付费,需要您自行承担本次实操的云资源费用。 本实验预计产生费用4.61/时,0.8元/G公网流量。如果您调整了资源规格、使用时长,或执行了本方案以外的操作,可能导致费用发生变化,请以控制台显示的实际价格和最终账单为准。 |

|

创建实验资源

|

|

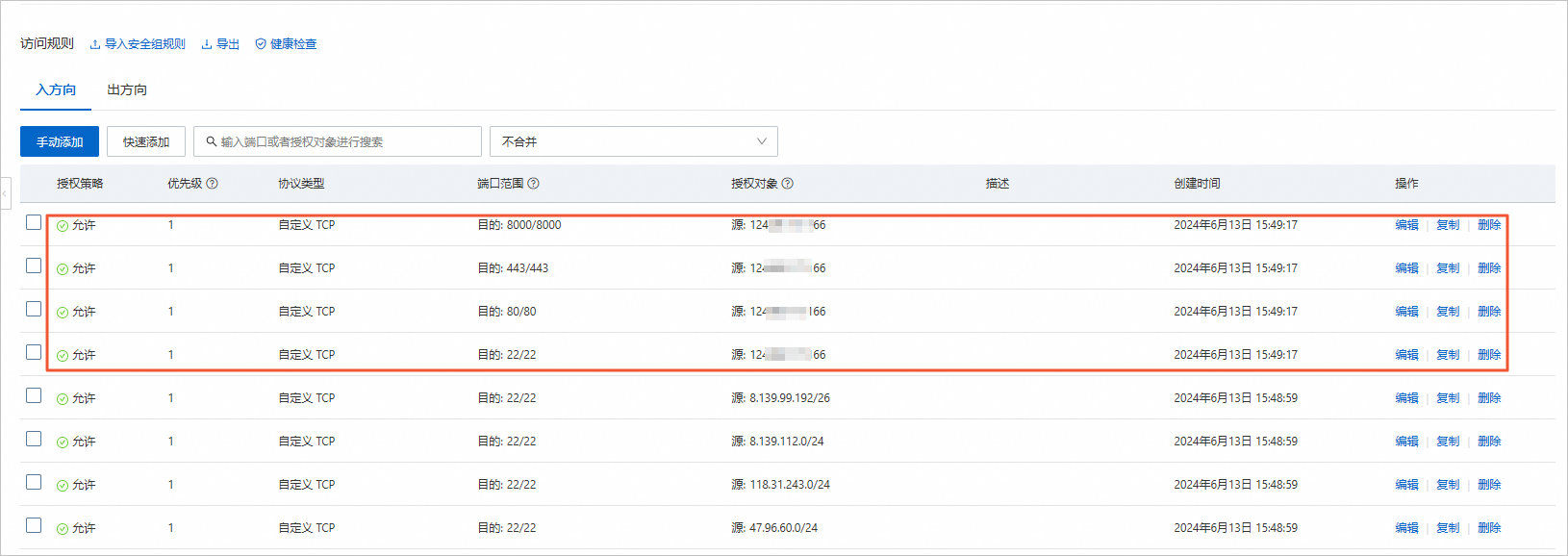

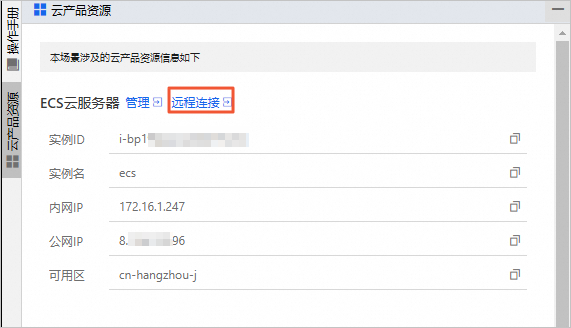

安全设置资源创建完成后,为了保护您阿里云主账号上资源的安全,请您重置云服务器ECS的登录密码、设置安全组端口。

|

|

准备系统环境首先需要添加系统组件,后续需要下载大模型与运行脚本。

|

|

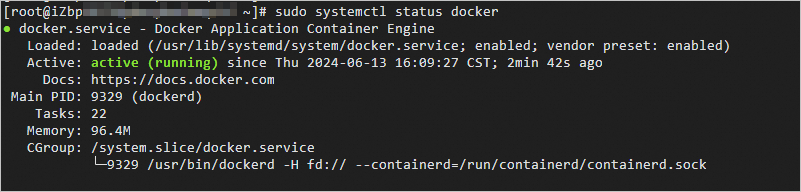

安装Docker使用AC2需要首先设置Docker运行环境。在Alibaba Cloud Linux 3上可以通过以下步骤安装Docker。

|

|

下载Qwen大模型与运行脚本由于Qwen运行环境镜像中并不包含大模型权重与运行脚本,您需要预先下载到本地。

|

|

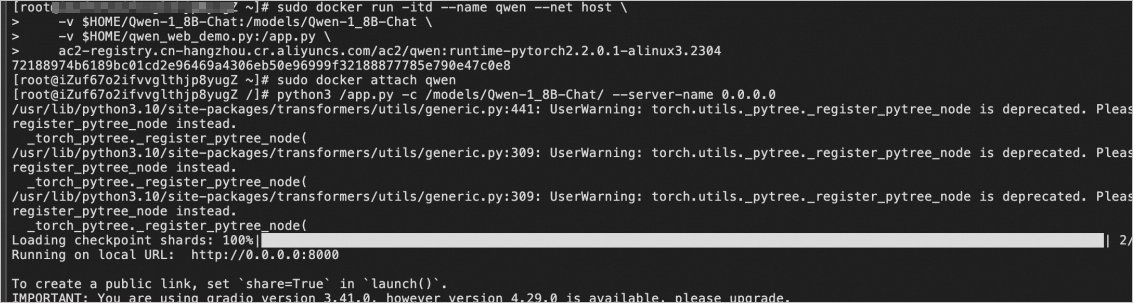

创建大模型容器Qwen系列镜像是Alibaba Cloud AI Containers(AC2)容器镜像服务推出的开箱即用大模型镜像。其中包含了运行Qwen系列大模型所需的所有依赖,包括Python运行环境、深度学习框架、模型权重文件以及依赖库。确保Qwen系列大模型能够高效、稳定地在不同环境下部署和服务。 下面将快速拉取AC2 Qwen运行环境镜像,并创建容器。

|

|

进入容器运行脚本接下来将进入容器环境,并运行大模型脚本。

|

|

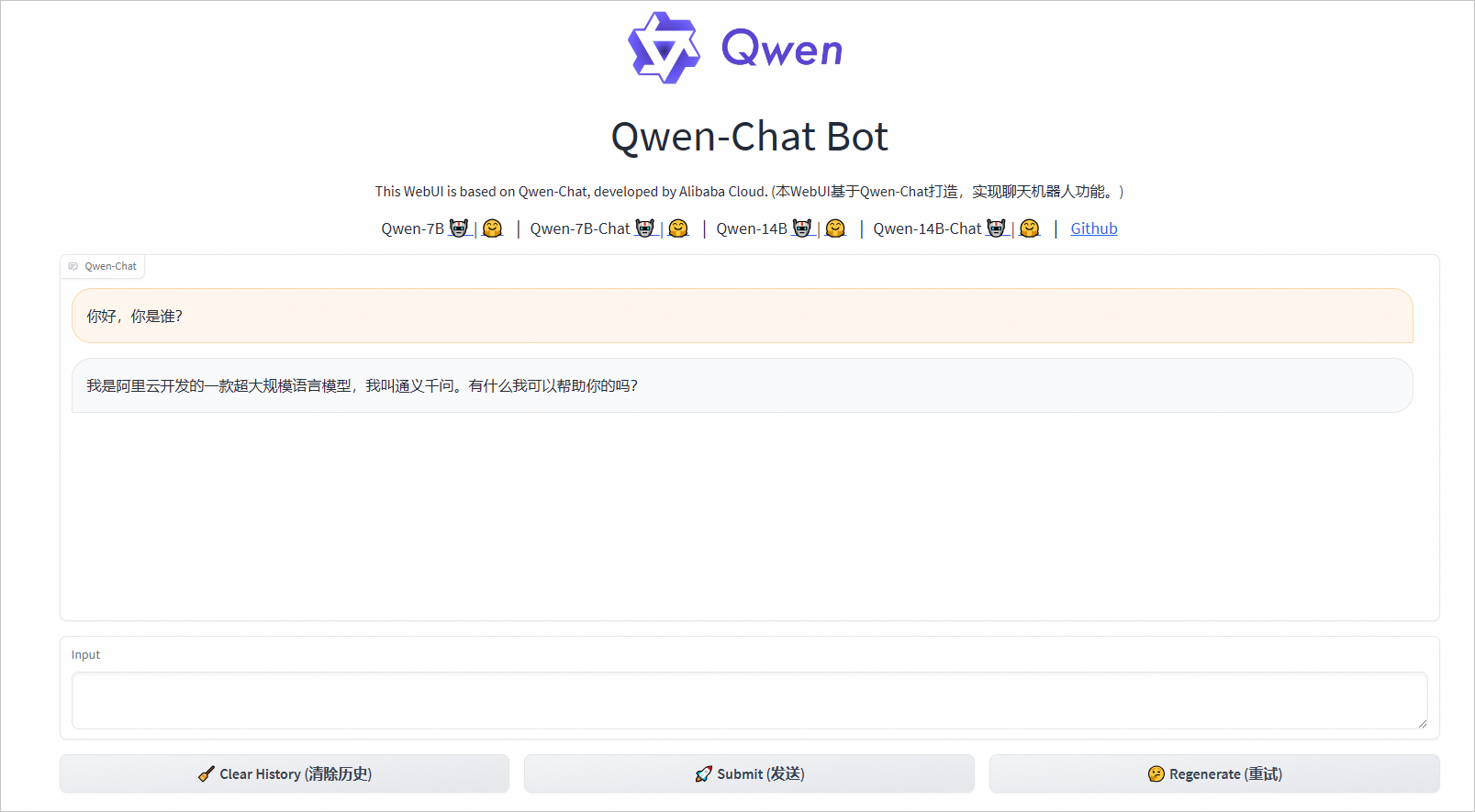

与Qwen大模型对话

|

|

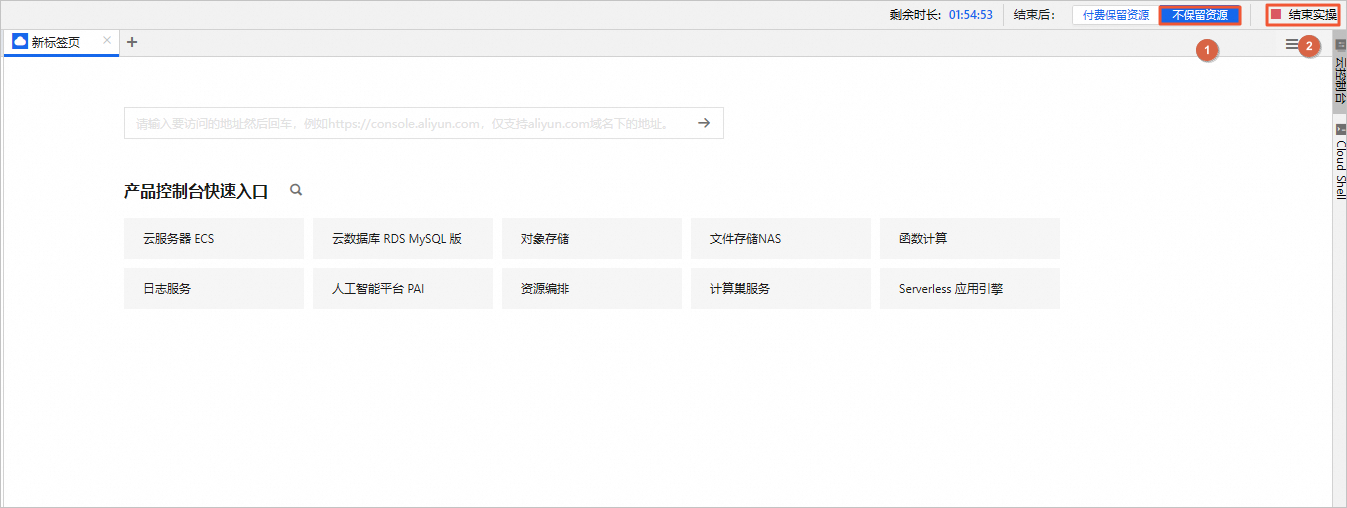

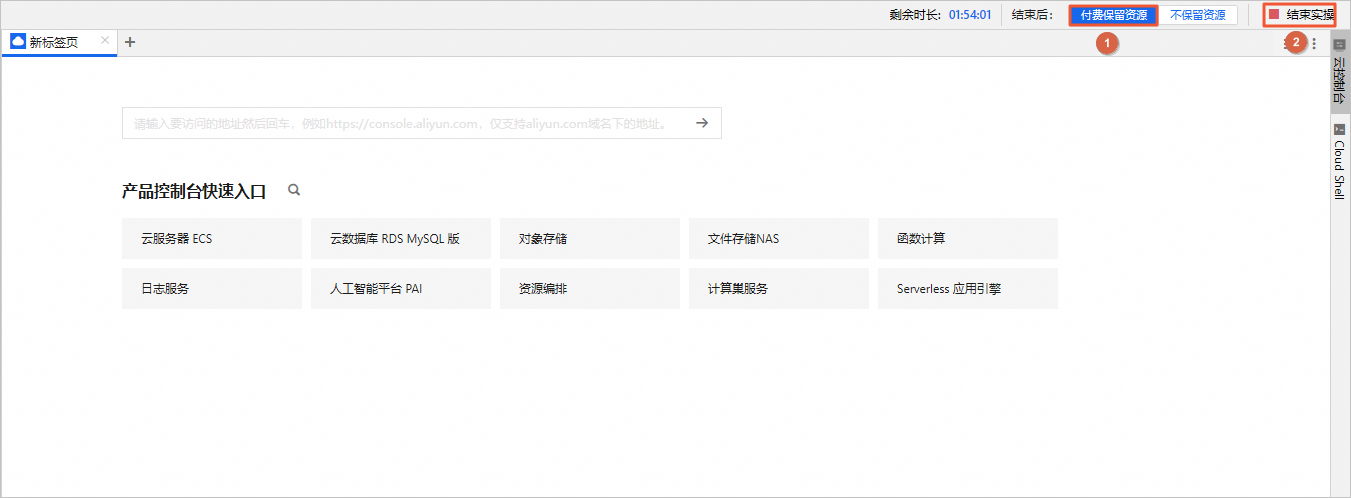

清理资源

|

|

【实践】使用AI容器镜像部署Qwen大语言模资源开通说明• 开始实操前,请确保您已通过 实名认证 且 账户余额 充足 • 资源开通在个人账号,默认时长60分钟 • 云资源产生的费用需您自行承担,云起实践平台不会向您征收额外费用 • 实操结束后,您可以选择继续付费保留资源,或参考手册自动/手动释放资源 包含云产品资源(4个):

云服务器 ECS

按量付费

ecs.g8i.4xlarge,16vCPU64GiB,100G ESSD

专有网络VPC

IPV4网段:172.16.0.0/12

云服务器 ECS

VSwitch

云服务器 ECS

安全组

|

|

|

|

|