你是否经历过与 AI Coding 工具协作编程时,对话越来越长,回答却开始变慢,甚至跑偏?在使用 AI Coding 工具过程中,是否觉得 tokens 消耗过快,越来越不经用?

Qoder 全新「上下文压缩」功能正式上线,高效管理会话上下文,节省开发成本,同时保持高效协作!

什么是上下文窗口?

上下文窗口(Context Window)可以理解成 AI 的“短期记忆”,它决定了模型在一次对话中能够“记住”并处理的信息总量。就像人脑的短期记忆有限一样,AI 会话的上下文窗口也有上限。当前 Qoder 选择支持 200K 上下文长度。

为什么需要管理?

随着会话的不断进行,这段“短期记忆”会越来越长,每次模型请求都需要处理窗口内的内容,才能准确理解你的意图。这会导致:

-

Credits 消耗增加: 每次请求处理的 Token 数量增多,则 Credits 消耗更多。

想象一下:在同一个会话中,当对话长达数十轮后,你可能只是想让 AI 修正一个变量名,但发给模型的却是全部历史对话(包含大量已解决的问题和无关代码)。

有效的上下文管理,可以通过总结会话,减少发送给模型的 Token 量,直接降低成本,让 Credits 消耗得更慢些。

-

响应变慢: 除了成本,上下文过载还会拖慢 AI 的响应速度。

就像让电脑处理一个巨大的文件,即便只是想在其中查找一个词,也需要更长的加载和分析时间。通过主动管理上下文,相当于为 AI 减轻了数据处理的负担,能提升其响应速度,让你重获流畅、即时的协作体验。

-

潜在干扰: 当上下文中混杂大量无关的历史信息时,AI 可能被旧信息误导,影响判断准确性。

例如,当你从调试一个旧模块转向开发一个新功能时,AI 可能会混淆不同阶段的方案,甚至被旧代码的逻辑所误导,从而给出不准确的建议。

Qoder 新能力上线上下文压缩

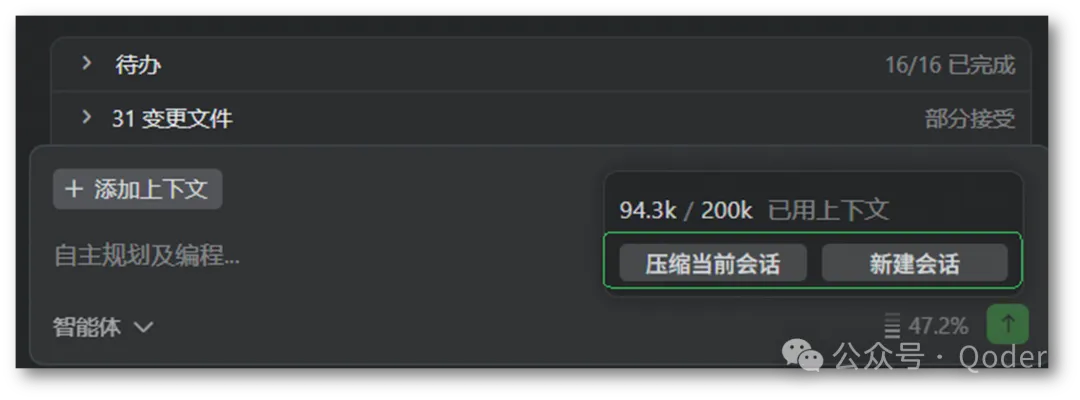

为了解决这些问题,让 AI 更节能、更高效地为你工作, Qoder 全新能力上线,让你可实时查看当前会话的上下文用量,并引导你在不同场景下适时采取相应措施。

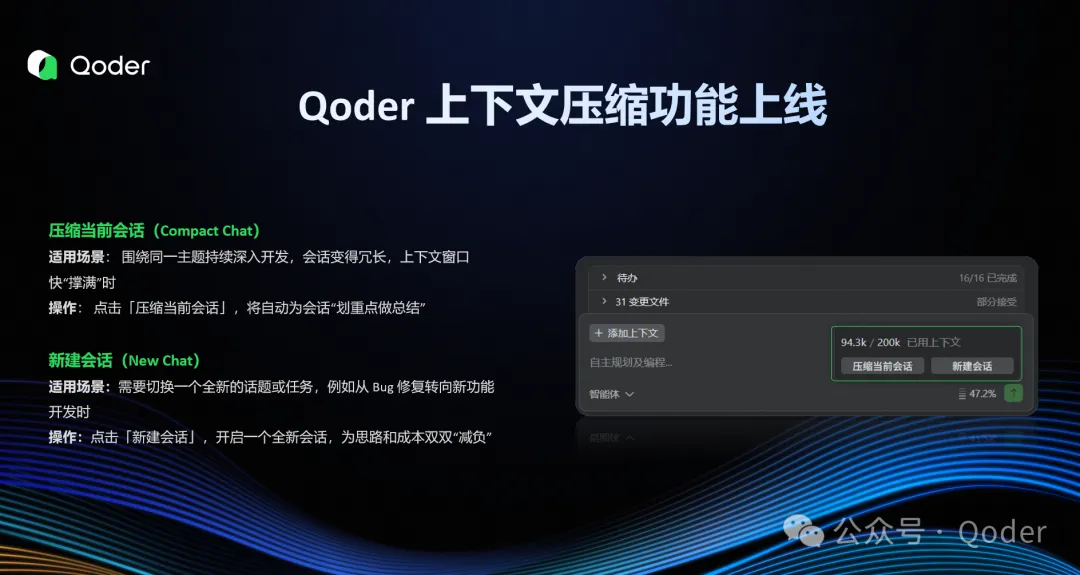

压缩当前会话(Compact Chat)

-

适用场景: 围绕同一主题持续深入开发,会话变得冗长,上下文窗口快“撑满”时。

-

操作: 点击「压缩当前会话」,将自动为会话“划重点做总结”:

- 智能总结: 保留关键代码逻辑等信息,剔除冗余内容,同时保留核心脉络。

- 效果立现: 有效降低 Credits 消耗,同时提升 AI 响应速度。

新建会话(New Chat)

-

适用场景: 需要切换一个全新的话题或任务,例如从 Bug 修复转向新功能开发时。

-

操作: 点击「新建会话」,即可开启一个全新会话,为思路和成本双双“减负”。

- 更准: 摆脱无关历史上下文干扰,让 AI 响应更精准。

- 更省: 避免因无关上下文导致的 Credits 浪费。

实战指南:变身上下文管理大师

理论结合实践,才能发挥最大威力。记住这几条法则,轻松驾驭上下文管理。

法则一:留意上下文用量,合理管理

在 Qoder 对话框右下角,可实时查看当前会话的上下文用量(例如:115.3k / 200k)。建议当用量超过总量 40% 时,考虑进行上下文压缩。

尤其发现 AI 回答偏离主题、响应变慢时,有可能是上下文过载所致。此时若仍需深入当前话题,执行一次压缩将有效节省 Credits 并提升响应效率。

法则二:新话题,新会话

开启全新的开发任务时,请果断创建新会话。这不仅能避免历史上下文干扰,提升 AI 理解与响应的准确性,还能有效减少上下文,节省 Credits,让新对话更高效、更经济。

欢迎更新到 Qoder 0.2.1 版本体验!

官网地址:

下载体验链接:https://qoder.com